NEWSLETTER ABONNIEREN

Sie interessieren sich für die Projekte und Ergebnisse unserer Zukunftslabore? Unser Newsletter fasst die wichtigsten Ereignisse alle zwei Monate zusammen.

Jetzt anmeldenDie industrielle Fertigung ist ein Zusammenspiel zahlreicher Produktionsschritte, die aufeinander abgestimmt und effizient gestaltet werden müssen. In Produktionslinien mit hohen Stückzahlen kommt es zum Verschleiß der Fertigungswerkzeuge. Dieser Verschleiß kann sich erheblich auf die Qualität der gefertigten Bauteile auswirken. Insbesondere in sicherheitskritischen Branchen wie der Automobilindustrie, die für Niedersachsen eine wichtige Rolle spielt, können schon minimale Abweichungen von der gewünschten Qualität enorme Schäden verursachen.

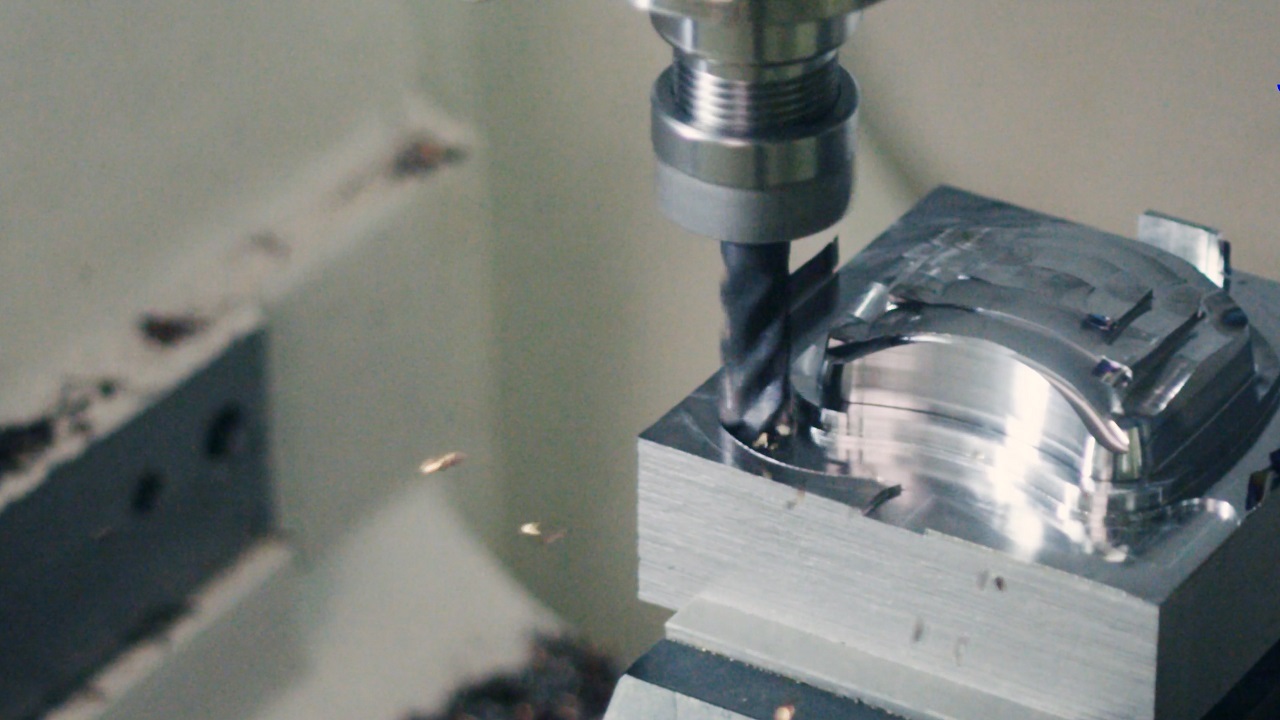

Daher untersuchen die Wissenschaftler*innen des Zukunftslabors Produktion Methoden des Maschinellen Lernens (ML), die dabei helfen, Qualitätsmängel in der Produktion vorherzusagen und somit Produktionsprozesse zu optimieren. Der Anwendungsfall ist der Verschleiß eines Fräswerkzeuges. Die ML-Modelle sollen vorhersagen, wie sich der Verschleiß auf die gefrästen Bauteile auswirkt. Beim Fräsen wird Material von einem Bauteil abgetragen, um es in eine bestimmte Form zu bringen. Es wird vor allem in der Metall- und Holzverarbeitung eingesetzt.

Erklärbarkeit und Zuverlässigkeit ML-basierter Vorhersagemodelle

Die Erklärbarkeit und Zuverlässigkeit der Vorhersagemodelle ist wichtig, um das Vertrauen und die Akzeptanz der Nutzer*innen zu steigern, Risiken zu minimieren und langfristig den Erfolg datengetriebener Ansätze in der Produktion zu sichern. Um die Erklärbarkeit und Zuverlässigkeit der Modelle zu untersuchen, analysierten die Wissenschaftler*innen die Zusammenhänge von Eingangsdaten und Vorhersagen mit Partial Dependence Plots. Dabei handelt es sich um Diagramme, die die Abhängigkeit von Dateninput und Prognose aufzeigen. Die Wissenschaftler*innen nahmen einen Wert (z. B. den Spindelstrom), variierten alle anderen Werte und prüften anschließend die Vorhersage. Auf diese Weise wurde der Zusammenhang zwischen einzelnen Dateninputs und Vorhersagen hergestellt. Mit diesem Vorgehen konnten auch die Grundzusammenhänge geprüft werden, die in den Modellen vorlagen, und festgestellt werden, ob die Modelle die richtigen Zusammenhänge gelernt haben. Des Weiteren betrachteten die Wissenschaftler*innen die Modellunsicherheit, also die Frage, inwieweit das Modell sicher bzw. unsicher mit seinen Vorhersagen ist. Konkret untersuchten sie die Aussagekraft von Modellunsicherheitsmaßen im Hinblick auf die Genauigkeit der prognostizierten Formfehler.

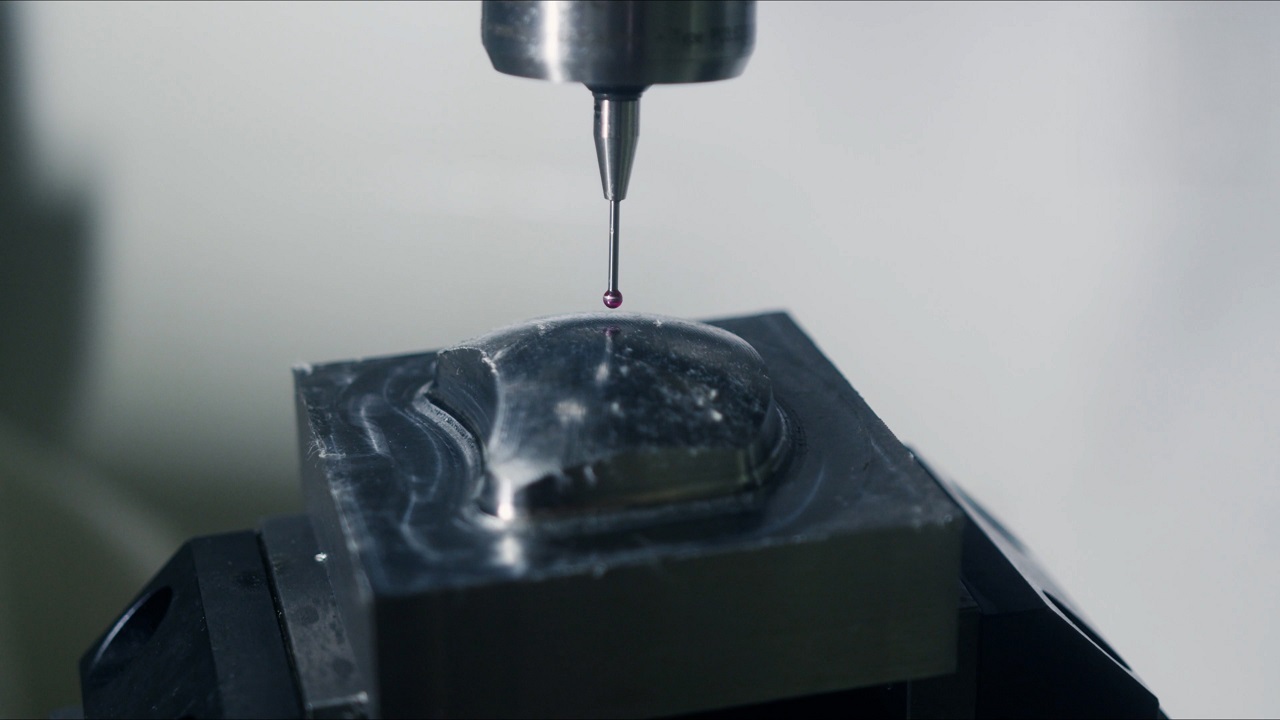

Die Trainingsdaten der Modelle stammten aus einem umfangreichen Datensatz, den die Wissenschaftler*innen erstellten. Dafür ließen sie einen Block aus Warmarbeitsstahl Ebene für Ebene abfräsen, wobei das Fräsen wellenförmig in verschiedenen Radien mit unterschiedlichen Bewegungen erfolgte (z. B. enge und weite Kurven). Nach jedem Fräsvorgang wurde ein Messtaster eingewechselt, der die Kontur des gefrästen Bauteils feinmaschig erfasste (0,05 mm bzw. 50 µm) und pro gefräster Ebene ca. 60.000 Messpunkte aufzeichnete. Insgesamt wurden fünf Fräswerkzeuge verschlissen und ein Datensatz von 306.456 Datenpunkten entstand.

Auswahl der Daten durch Active Learning

Wenn der Fall eintritt, dass die Datenbasis für eine sichere Prognose nicht ausreicht, können über Active Learning neue Datenpunkte zugeführt werden. Beim Active Learning wählt das Modell selbstständig die Daten (also einzelne Messungen am Bauteil) aus, die es für die Prognose der Formabweichungen benötigt. Es informiert den Messtaster, an welchen Stellen er die Form(abweichung) messen soll. Die Wissenschaftler*innen führten unterschiedliche Experimente durch, um die Vorteile dieser modellbasierten Datenauswahl mittels Active Learning zu prüfen. Hierfür variierten sie u. a. die Gewichtung verschiedener Faktoren zur Auswahl der Daten. Ein wichtiger Faktor war die Modellunsicherheit bei einer Vorhersage des Formfehlers an der entsprechenden Stelle, wobei bevorzugt Stellen mit erhöhter Modellunsicherheit gemessen werden sollten.

Active Learning macht es möglich, dass das Modell selbstständig die wichtigsten Messpunkte auswählt, um noch bessere Prognosen zu Formfehlern zu liefern. Damit können wir effizient zusätzliche Daten gewinnen und die Prozessüberwachung in Echtzeit verbessern – ein großer Vorteil für präzise Fertigung.

Des Weiteren untersuchten die Wissenschaftler*innen die Abdeckung der Produktionsbedingungen des potenziellen Messpunktes anhand der Fragen: Welche Kraft wirkt am Fräser in Vorschubrichtung? Welche Kraft wirkt beim Zerspanen? Welche Spindelströme liegen vor? Wenn ein Datenpunkt von den bisherigen Punkten im Trainingsdatensatz stark abweicht (z. B. weil eine höhere Kraft wirkte), dann ist diese Situation noch nicht abgedeckt und der Datenpunkt kann dem Modell neue Informationen liefern.

Analysen am Beispiel der Gauß-Prozess-Regression (GPR) und Random Forest (RF)

Bei den untersuchten Modellen handelte es sich um die Gauß-Prozess-Regression und um Random Forest. Die Gauß-Prozess-Regression wird zur Vorhersage kontinuierlicher Werte verwendet. Sie basiert auf der Annahme, dass die Daten von einem sogenannten Gauß-Prozess (also einem stochastischen Prozess) ausgewählt werden. Bei Random Forest handelt sich um ein Ensemble-Lernverfahren, bei dem mehrere Entscheidungsbäume (also einzelne Modelle) trainiert werden, um eine Vorhersage zu treffen. Bei der Erstellung jedes Entscheidungsbaums wird ein zufälliger Teil der Daten verwendet.

Der Vergleich der Gauß-Prozess-Regression und des Random Forest zeigte, dass die GPR eine gute Einschätzung zur Unsicherheit lieferte, aber die verschleißbedingten Formabweichungen weniger genau vorhersagte. Es zeigte sich ein leichter, aber konsistenter Zusammenhang zwischen der Unsicherheit des Modells und den vorhergesagten Formabweichungen: Je sicherer das Modell der Gauß-Prozess-Regression war, desto genauer waren die Vorhersagen – je unsicherer es war, desto ungenauer waren die Prognosen. Um die Vorhersage der Gauß-Prozess-Regression zu verbessern, sollte sichergestellt werden, dass Daten zu allen Bereichen des Bauteils vorliegen.

Bei Random Forest war es umgekehrt: Die Vorhersage der Formabweichungen war genauer, jedoch lieferte RF keine Aussagen zur Unsicherheit. Deshalb mussten die Wissenschaftler*innen hier auf ein unabhängiges Unsicherheitsmaß zurückgreifen, z. B. die Übereinstimmung der Vorhersagen der einzelnen Entscheidungsbäume. Die Wissenschaftler*innen erkannten einen direkten Zusammenhang zwischen der Datengrundlage und den Vorhersagefehlern: Wenn das Modell bereits mit Daten mehrerer Bauteile trainiert war, die Datengrundlage aber noch nicht ausreichte, waren die Vorhersagen ungenauer. Bei beiden Modellen stellt Active Learning eine sinnvolle Ergänzung dar, damit die Modelle die Daten, die sie für eine sichere Prognose benötigen, autonom einholen.